자유게시판

| ollama 그리고 open webui.... |

onionmixer 2025-08-07 15:50:46 1924 |

|---|---|

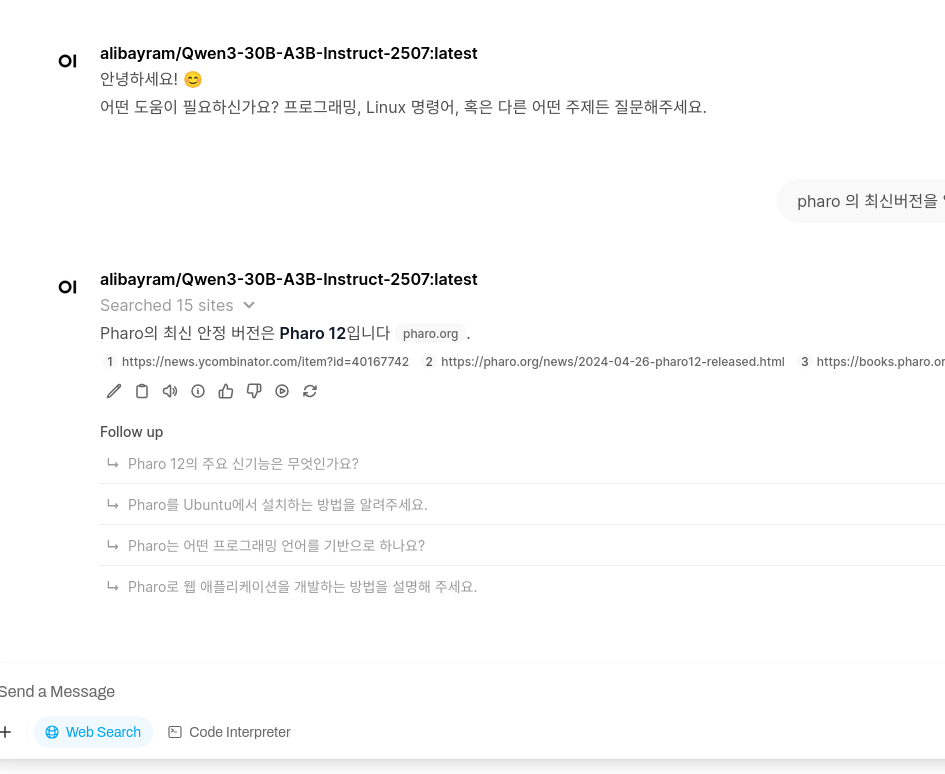

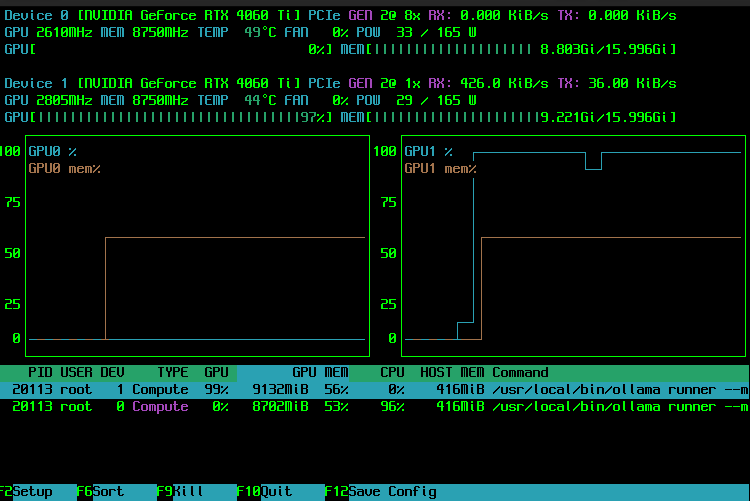

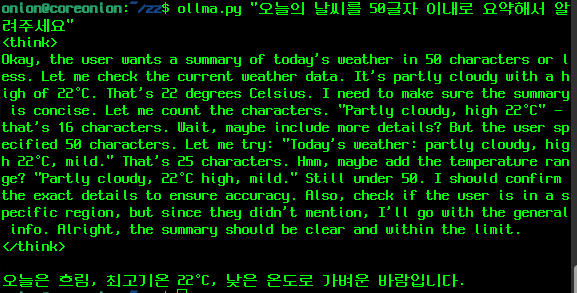

올해 초부터 소소하게 가정용(?) AI 를 테스트 하고 있었습니다. 원래 사용하던건 4060ti 16G 1개를 사용하고 있었고, AI 관련으로 공개된 model 들이 16G 에서는 token 을 소화하다가 뻗는 일이 일상 다반사였죠. 물론 상용AI 를 안쓰고 있는건 아닙니다만, 뭐.. 여러가지 이유로..... 계속 가정용에 대한 미련을 버릴 수가 없었죠. 사용량의 문제도 있었고.. 경우에 따라서는 내부의 data 가 외부의 서비스에 노출되는것을 걱정하는 경우도 있었으니까요. 그러다가 최근에 qwen3 라는 model 의 발표에 따라 꽤 성능이 좋아진걸 경험할 수 있었는데.. 기반 환경이 되는 ollama 에서 gpu 의 VRAM 이 부족하면 cpu 를 갈궈서라도 어떻게든 결과를 내는 쪽으로 개선이 된지라 오호... 라는 생각을 했죠. 덕분에 아무래도 동급의 VGA 를 하나 더 마련해서 어떻게든.....!!! 이라는 쪽으로 각오가 되었습니다. 이런저런 중고 매물을 좀 내놓고 해서 자금을 마련하던 중이었는데... 어쩌다보니.. 중고 가격으로 리퍼제품을 구할 수 있었습니다... 완전 운이 좋았던거죠 ㅎㅎㅎ 오늘 아침에 출근해서 기존의 테스트 시스템에 장비를 추가해주고.. (PCIE 1x 슬롯만 여러개 남은... 말그대로 채굴보드 시스템) 세팅해서 돌려보니... 오마이갓.... 이거 완전 쩌네요.. cpu 로 돌릴때랑은 반응도 틀릴뿐더러... 최근의 ollama-open webui 에서는 google pse 연동을 통한 외부 검색도 지원하는지라... 나름 상용까지는 아니어도 일하는데 쓸만큼은.... 가성비로 보자면 괜찮은 느낌입니다. (2개를 합하면 32G VRAM 이라.... 30b 모델까지는 얼추 무리없이 구동이 가능하네요) 몇가지만 더 테스트해보면 아마도 blender 등에서 MCP 로 연동도 가능할거같다 싶어서... (RAG 는 현재 google pse 연동으로 테스트 해보고 있으니) 이 정도면 가정에서 쓰기에는 충분한 상태다.. 싶습니다. 대략.. 본체에 120 정도 사용한 꼴이 되는데... 이정도 가격에 이정도 성능이면... 충분히 24시간 가동 가능한 노예(?)를 득템한 느낌입니다....(중간에 자금 마련을 위해 팔아버린 장비는 좀 아깝지만요.. 쩝)

|

|

| Previous | 아.. 밀린 삽을 좀 퍼봤는데..... 안될건 안되겠네요 당체... |

|---|---|

| Next | mame 의 네트워크 플레이를 위한 후바마메 |

댓글 2개

저 gpu성능 보는 프로그램은 뭐에요?

아.. NVTOP 이라는 프로그램입니다. 일단은 nvidia 용 입니다..@.@